Waarom moeten we het gebruik van AI reguleren?

In een recente publicatie geeft de Europese Commissie beknopte antwoorden op de belangrijkste vragen rondom de EU AI-Verordening.

De opkomst van AI-systemen heeft een groot potentieel om maatschappelijke voordelen te brengen, economische groei te stimuleren en de innovatie en wereldwijde concurrentiekracht van de EU te verbeteren. In bepaalde gevallen kunnen de specifieke kenmerken van bepaalde AI-systemen echter nieuwe risico's met zich meebrengen met betrekking tot de veiligheid van gebruikers, waaronder fysieke veiligheid, en fundamentele rechten. Dit leidt tot juridische onzekerheid en mogelijk tragere acceptatie van AI-technologieën door overheden, bedrijven en burgers, vanwege het gebrek aan vertrouwen. Verschillende regelgevende reacties door nationale autoriteiten zouden het risico met zich meebrengen dat de interne markt gefragmenteerd raakt.

De EU AI-verordening 2024/1689 (verder: AI-verordening) is de eerste uitgebreide AI-wet ter wereld. Het doel van deze wetgeving is om de risico's voor gezondheid, veiligheid en fundamentele rechten aan te pakken, en de democratie, de rechtsstaat en het milieu te beschermen, en voor een goed functionerende interne markt voor AI-systemen, met een adequate aanpak van zowel de voordelen als de risico's van AI-technologieën te zorgen.

Op wie is de AI-verordening van toepassing?

Het juridische kader zal van toepassing zijn op zowel publieke als private actoren binnen en buiten de EU, zolang het AI-systeem op de Europese markt beschikbaar wordt gesteld of het gebruik ervan invloed heeft op mensen binnen de EU. De verplichtingen kunnen zowel van invloed zijn op aanbieders (bijv. een ontwikkelaar van een CV-screeningstool) als op gebruikers van AI-systemen (bijv. een bank die deze screeningstool aanschaft). Er zijn ook bepaalde uitzonderingen die niet onder deze regelgeving vallen, zoals onderzoeks-, ontwikkelings- en prototypingactiviteiten die plaatsvinden voordat een AI-systeem op de markt wordt gebracht, of AI-systemen die exclusief zijn ontworpen voor militaire, defensie- of nationale veiligheidsdoeleinden.

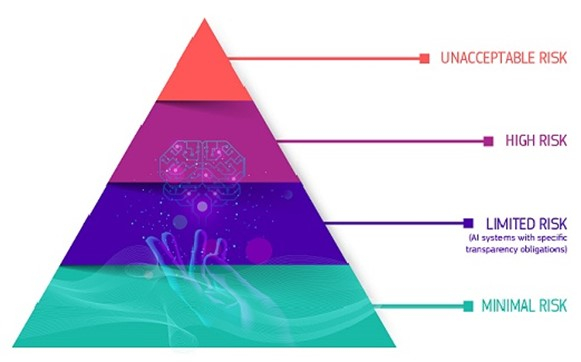

Wat zijn de risicocategorieën?

De AI-verordening introduceert een uniform kader voor alle EU-lidstaten, gebaseerd op een toekomstgerichte definitie van AI en een risicogebaseerde benadering:

Bron afbeelding: AI Act | Shaping Europe’s digital future (europa.eu)

- Onaanvaardbaar risico: Een zeer beperkt aantal bijzonder schadelijke toepassingen van AI die in strijd zijn met de EU-waarden omdat ze fundamentele rechten schenden, zullen daarom verboden worden. Dit betreft bijvoorbeeld de exploitatie van kwetsbaarheden van personen, manipulatie en het gebruik van subliminale technieken, sociale scoring voor publieke en private doeleinden.

- Hoog risico: Een beperkt aantal AI-systemen die in het voorstel zijn gedefinieerd en mogelijk een negatief effect kunnen hebben op de veiligheid van mensen of hun fundamentele rechten. Voorbeelden van hoogrisico-AI-systemen zijn systemen die beoordelen of iemand een bepaalde medische behandeling kan krijgen, een bepaalde baan of lening kan krijgen om een appartement te kopen. Andere hoogrisico-AI-systemen zijn systemen die door de politie worden gebruikt voor het profileren van mensen of het beoordelen van hun risico op het plegen van een misdaad. En hoog risico kan ook gelden voor AI-systemen die robots, drones of medische apparatuur aansturen.

- Beperkt risico (specifieke transparantie verplichting): Om het vertrouwen te bevorderen, is het belangrijk om transparantie te waarborgen rondom het gebruik van AI. Daarom introduceert de AI-Verordening specifieke transparantievereisten voor bepaalde AI-toepassingen, bijvoorbeeld waar er een duidelijk risico op manipulatie is (bijv. via het gebruik van chatbots) of deep fakes. Gebruikers moeten zich ervan bewust zijn dat ze met een machine communiceren.

- Minimaal risico: De meerderheid van de AI-systemen kan onder de bestaande wetgeving worden ontwikkeld en gebruikt zonder aanvullende wettelijke verplichtingen. Aanbieders van deze systemen kunnen er vrijwillig voor kiezen om de vereisten voor betrouwbare AI toe te passen en zich te houden aan de vrijwillige gedragscodes te houden. Daarnaast houdt de AI-verordening rekening met de ‘systemische risico's’ die kunnen ontstaan door o.a. ‘grote generatieve AI-modellen’. Deze kunnen voor verschillende taken worden gebruikt en vormen de basis voor veel AI-systemen in de EU. Sommige van deze modellen kunnen systemische risico's met zich meebrengen, bijvoorbeeld, krachtige modellen zouden ernstige ongelukken kunnen veroorzaken of kunnen worden misbruikt voor vergaande cyberaanvallen.

Hoe weet ik of een AI-systeem als hoog risico wordt beschouwd?

De AI-verordening bevat een methodologie voor de classificatie van AI-systemen als hoog risico. De risicoclassificatie is gebaseerd op het beoogde doel van het AI-systeem, in overeenstemming met de bestaande EU-wetgeving inzake productveiligheid. Dit betekent dat de classificatie afhangt van de functie die door het AI-systeem wordt uitgevoerd en van het specifieke doel en de modaliteiten waarvoor het systeem wordt gebruikt. AI-systemen kunnen als hoog risico worden geclassificeerd in twee gevallen: Als het AI-systeem is ingebouwd als een veiligheidscomponent in producten die onder de bestaande productwetgeving vallen, of als het dergelijke producten zelf vormt. Dit zou bijvoorbeeld AI-gebaseerde medische software kunnen zijn.

De Commissie bereidt richtlijnen voor over de hoogrisicoclassificatie, die zullen worden gepubliceerd voordat de regels in werking treden.

Wil je meer weten over de AI-Verordening, bijvoorbeeld wat de verplichtingen voor aanbieders van hoog risico AI-systemen zijn, hoe biometrische identificatie gereguleerd wordt, of door wie en wanneer een fundamentele rechten beoordeling uitgevoerd dient te worden?

De volledige publicatie van de Europese Commissie is hier te lezen:

Artificial Intelligence – Q&As (europa.eu)

Maar u kunt natuurlijk ook met ons contact opnemen.